Le NeRF rappresentano scene 3D in una rete neurale. Un nuovo lavoro di un team internazionale che include il Politecnico di Zurigo apre la tecnologia AI alle scene dinamiche.

Nell'estate 2020, i ricercatori di Google hanno presentato Campi di irradiazione neurale (NERF) ha in programma il lancio di un AI-processo in grado di estrarre dati di profondità 3D da immagini 2D come le foto. Il NERF può quindi creare un modello 3D strutturato da più foto scattate da angolazioni diverse. I Neural Radiance Fields (NeRF) possono così renderizzare scene 3D da angolazioni inedite. Questo permette, ad esempio, di fare un giro a 360 gradi con la telecamera intorno a un oggetto, un giro con un drone o un volo all'interno di un ristorante. La tecnologia può quindi essere utilizzata per generare oggetti 3D foto-realistici.

Nella quasi totalità dei casi, tuttavia, si tratta di scene o oggetti statici, poiché i movimenti introducono una dimensione temporale nel processo di addestramento che finora è stato difficile risolvere.

NeRF per scene dinamiche

In un nuovo documento di ricerca, un team dell'Università di Buffalo, del Politecnico di Zurigo, di InnoPeak Technology e dell'Università di Tubinga mostra ora come i NeRF possano rappresentare scene dinamiche e quindi apprendere una rappresentazione 4D.

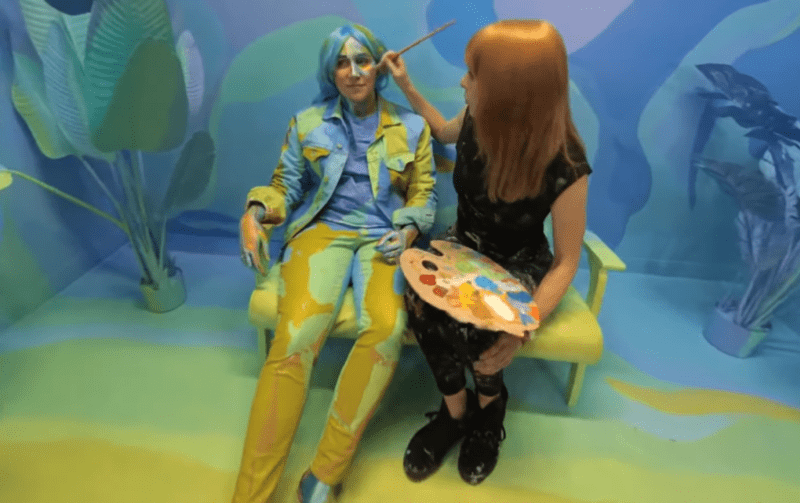

Come input vengono utilizzate immagini RGB provenienti da diverse telecamere o da una singola telecamera in movimento. Le immagini mostrano persone in movimento o qualcuno che versa del caffè in un bicchiere.

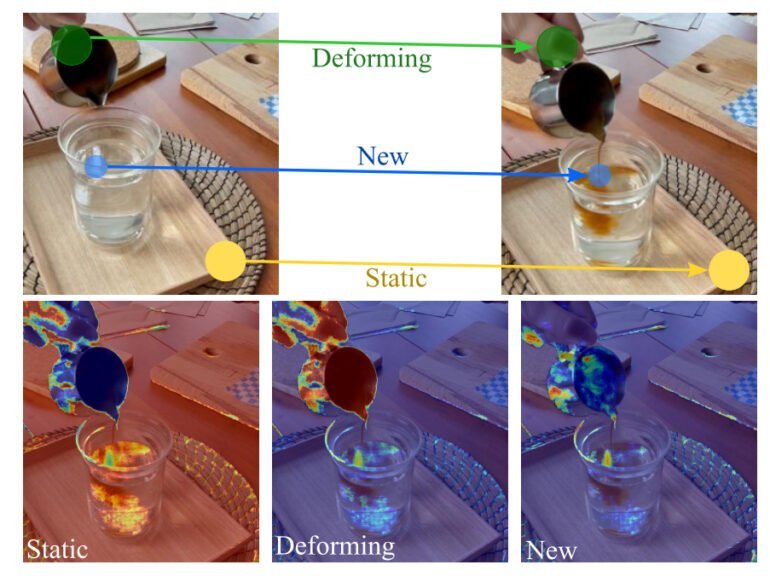

Affinché i NeRF imparino le scene dinamiche, un cosiddetto campo di decomposizione divide la scena in diverse aree e poi il team divide le scene dinamiche in tre modelli temporali: aree statiche, deformanti e nuove.

Affinché i NeRF imparino le scene dinamiche, un cosiddetto campo di decomposizione divide la scena in diverse aree e poi il team divide le scene dinamiche in tre modelli temporali: aree statiche, deformanti e nuove.

Nel caso del caffè, ad esempio, la tavola di legno su cui poggia il bicchiere rimane statica. Il contenuto del bicchiere appare di nuovo e la mano visibile si deforma. Un campo di decomposizione si occupa della divisione della scena nelle tre categorie. Ogni area è rappresentata da un proprio campo neurale. Nel loro approccio, i ricercatori disaccoppiano anche le dimensioni temporali e spaziali per migliorare la rappresentazione.

La realtà virtuale come visione

La rappresentazione scomposta della scena dinamica riduce significativamente gli artefatti visivi rispetto ad altri approcci. Il team ha anche dimostrato con NeRFPlayer un modo per trasmettere in streaming le rappresentazioni apprese in tempo reale con velocità di trasmissione limitate.

Attraverso il framework di Nvidia InstantNGPIl metodo presentato è altrettanto veloce, in quanto consente a una rete neurale di apprendere in pochi secondi rappresentazioni di immagini gigapixel, oggetti 3D e NeRF.

Nel lavoro, il team descrive l'esplorazione visiva di un vero ambiente spazio-temporale 4D per la realtà virtuale come una visione e vede il proprio lavoro come un contributo a questo obiettivo.

"L'esplorazione visiva di uno spazio reale 4D liberamente in VR è un compito di lunga data. Questo compito è particolarmente interessante quando per catturare la scena dinamica si utilizzano poche o addirittura una sola telecamera RGB", si legge nel documento.

Le dimostrazioni NeRF hanno origine da un documento di ricerca di Google del 2020 sui video di campi luminosi ripresi spazialmente.