Les NeRF représentent des scènes en 3D dans un réseau neuronal. Un nouveau travail d'une équipe internationale, dont fait partie l'EPF de Zurich, ouvre la technologie de l'IA à des scènes dynamiques.

En été 2020, des chercheurs de Google ont présenté Champs de rayonnement neuronal (NERF) propose de créer un IA-qui permet d'extraire des données 3D en profondeur à partir d'images 2D telles que des photos. NERF peut ainsi créer un modèle 3D texturé à partir de plusieurs photos prises sous des angles différents. Les Neural Radiance Fields (NeRF) peuvent ainsi rendre des scènes 3D sous des angles invisibles auparavant. Cela permet par exemple de faire un tour de caméra à 360 degrés autour d'un objet, une visite par enregistrement de drone ou un vol à l'intérieur d'un restaurant. La technologie peut ainsi être utilisée pour générer des objets 3D photoréalistes.

Dans presque tous les cas, il s'agit toutefois de scènes ou d'objets statiques, car les mouvements introduisent une dimension temporelle dans le processus d'entraînement, ce qui était jusqu'à présent difficile à résoudre.

NeRFs pour les scènes dynamiques

Dans un nouveau travail de recherche, une équipe de l'Université de Buffalo, de l'EPF Zurich, d'InnoPeak Technology et de l'Université de Tübingen montre maintenant comment les NeRF peuvent représenter des scènes dynamiques et apprendre ainsi une représentation 4D.

Les images RVB de différentes caméras ou d'une seule caméra en mouvement servent d'entrée. Les images montrent par exemple des personnes en mouvement ou quelqu'un qui verse du café dans un verre.

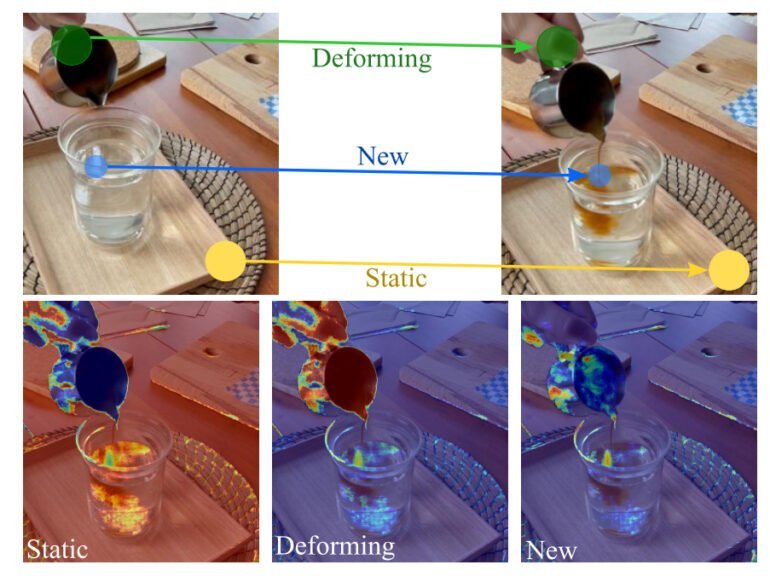

Pour que les NeRF apprennent des scènes dynamiques, un champ dit de décomposition divise la scène en différentes zones, puis l'équipe divise les scènes dynamiques en trois modèles temporels : statique, déformant et nouvelles zones.

Pour que les NeRF apprennent des scènes dynamiques, un champ dit de décomposition divise la scène en différentes zones, puis l'équipe divise les scènes dynamiques en trois modèles temporels : statique, déformant et nouvelles zones.

Dans le cas du café, la planche de bois sur laquelle repose le verre reste statique. Le contenu du verre apparaît sous une nouvelle forme et la main visible se déforme. Un champ de décomposition se charge de diviser la scène en trois catégories. Chaque zone est représentée par un champ neuronal distinct. Dans leur approche, les chercheurs dissocient en outre les dimensions temporelles et spatiales afin d'améliorer la représentation.

La réalité virtuelle comme vision

La représentation décompositionnelle de la scène dynamique réduit considérablement les artefacts visuels par rapport à d'autres approches. L'équipe présente également NeRFPlayer, un moyen de diffuser en temps réel les représentations apprises avec des débits binaires limités.

Grâce au framework de Nvidia InstantNGPLa méthode présentée est également rapide, grâce à l'utilisation d'un réseau neuronal capable d'apprendre en quelques secondes des représentations d'images gigapixels, d'objets 3D et de NeRF.

Dans son travail, l'équipe décrit l'exploration visuelle d'un environnement spatio-temporel 4D réel pour la réalité virtuelle comme une vision et considère son propre travail comme une contribution à cet objectif.

"Explorer visuellement un espace 4D réel librement en VR est une tâche de longue haleine. La tâche est particulièrement stimulante lorsque peu de caméras RVB, voire une seule, sont utilisées pour capturer la scène dynamique", peut-on lire dans le document.

Les démonstrations NeRF trouvent leur origine dans un travail de recherche de Google datant de 2020 sur les vidéos de champs lumineux filmées dans l'espace.